README.ru.md

История машинного обучения

Заметка Томоми Имура

Тест перед лекцией

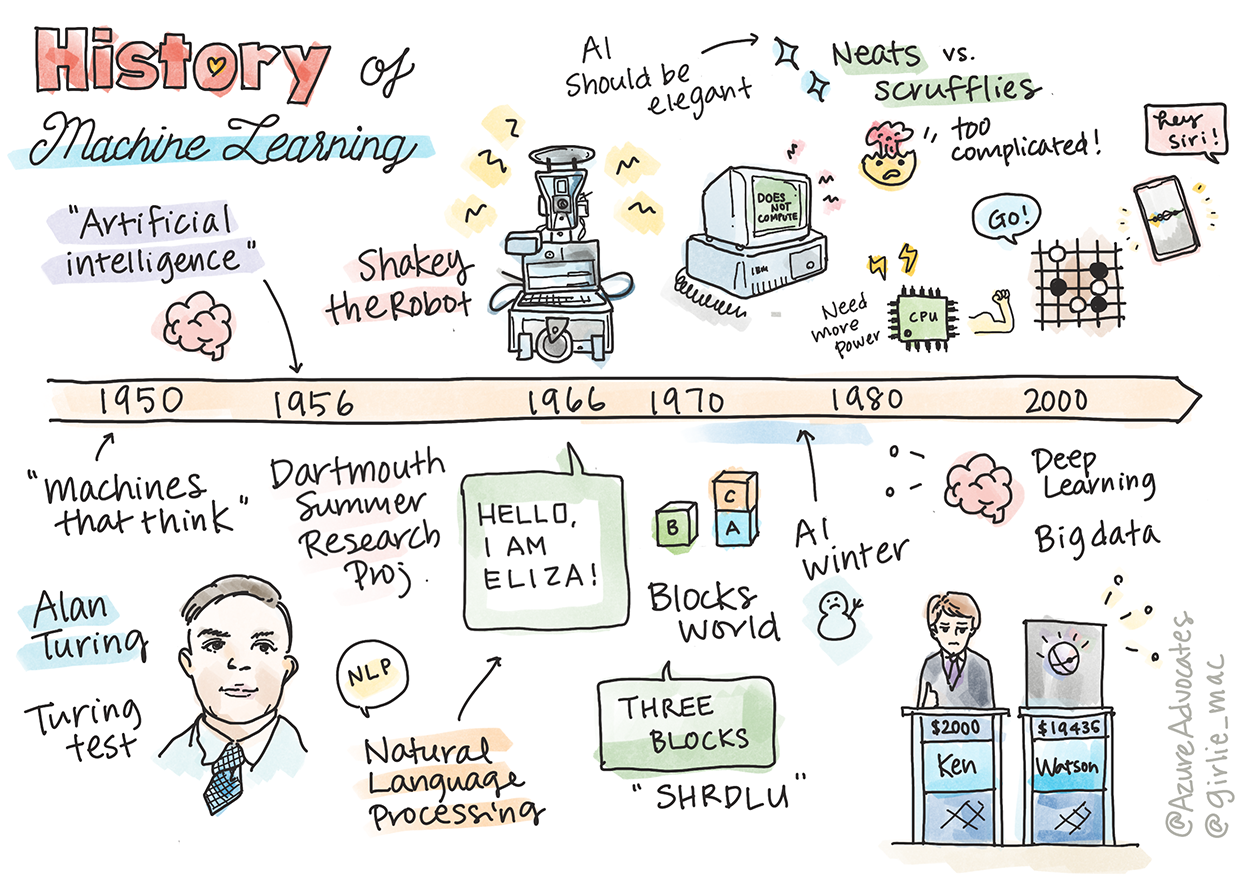

На этом уроке мы рассмотрим основные вехи в истории машинного обучения и искусственного интеллекта.

История искусственного интеллекта (ИИ) как области переплетается с историей машинного обучения (machine learning, ML), поскольку алгоритмы и вычислительные достижения, лежащие в основе ML, способствовали развитию ИИ. Полезно помнить, что, хотя эти области как начали выделяться в отдельные в 1950-х годах, важные алгоритмические, статистические, математические, вычислительные и технические открытия предшествовали и происходили в эту эпоху. На самом деле, люди думали об этих вопросах в течение сотен лет: в этой статье рассматриваются исторические интеллектуальные основы идеи "мыслящей машины".

Заметные открытия

- 1763, 1812 Теорема Байеса и ее предшественники. Эта теорема и ее приложения лежат в основе вывода, описывающего вероятность события, происходящего на основе предварительных знаний.

- 1805 Теория наименьших квадратов французского математика Адриена-Мари Лежандра. Эта теория, о которой вы узнаете в нашем блоке регрессии, помогает в аппроксимации данных.

- 1913 Цепи Маркова, названный в честь русского математика Андрея Маркова, используется для описания последовательности возможных событий на основе предыдущего состояния.

- 1957 Персептрон - это тип линейного классификатора, изобретенный американским психологом Фрэнком Розенблаттом, который лежит в основе достижений в области глубокого обучения.

- 1967 Метод ближайшего соседа - это алгоритм, изначально разработанный для отображения маршрутов. В контексте ML он используется для обнаружения закономерностей.

- 1970 Обратное распространение ошибки используется для обучения нейронных сетей с прямой связью.

- 1982 Рекуррентные нейронные сети являются искусственными нейронными сетями, полученными из нейронных сетей прямой связи, которые создают временные графики.

✅ Проведите небольшое исследование. Какие еще даты являются ключевыми в истории ML и ИИ?

1950: Машины, которые думают

Алан Тьюринг, поистине великий человек, который был выбран общественностью в 2019 году величайшим ученым 20-го века. Считается, что он помог заложить основу концепции "машины, которая может мыслить". Он боролся со скептиками и своей собственной потребностью в эмпирических доказательствах этой концепции, частично создав Тест Тьюринга, которые вы изучите на наших уроках NLP.

1956: Летний исследовательский проект в Дартмуте

"Летний исследовательский проект Дартмута по искусственному интеллекту был основополагающим событием для искусственного интеллекта как области", и именно здесь был придуман термин "искусственный интеллект" (источник).

Всякий аспект обучения или любое другое свойство интеллекта может в принципе быть столь точно описано, что машина сможет его симулировать.

Ведущий исследователь, профессор математики Джон Маккарти, надеялся "действовать, основываясь на предположении, что всякий аспект обучения или любое другое свойство интеллекта может в принципе быть столь точно описано, что машина сможет его симулировать". Среди участников был еще один выдающийся ученый в этой области - Марвин Мински.

Семинару приписывают инициирование и поощрение нескольких дискуссий, в том числе "развитие символических методов, систем, ориентированных на ограниченные области (ранние экспертные системы), и дедуктивных систем по сравнению с индуктивными системами". (источник).

1956 - 1974: "Золотые годы"

С 1950-х до середины 70-х годов оптимизм рос в надежде, что ИИ сможет решить многие проблемы. В 1967 году Марвин Мински уверенно заявил, что "В течение одного поколения... проблема создания "искусственного интеллекта" будет в значительной степени решена". (Мински, Марвин (1967), Вычисления: Конечные и бесконечные машины, Энглвуд-Клиффс, Нью-Джерси: Прентис-Холл)

Исследования в области обработки естественного языка процветали, поиск был усовершенствован и стал более мощным, и была создана концепция "микромиров", где простые задачи выполнялись с использованием простых языковых инструкций.

Исследования хорошо финансировались правительственными учреждениями, были достигнуты успехи в вычислениях и алгоритмах, были созданы прототипы интеллектуальных машин. Некоторые из этих машин включают:

-

Робот Shakey, который мог маневрировать и решать, как "разумно" выполнять задачи.

Shakey в 1972 году

-

Элиза, ранний "чат-бот", могла общаться с людьми и действовать как примитивный "терапевт". Вы узнаете больше об Элизе на уроках NLP.

Версия Элизы, чат-бота

-

"Мир блоков" был примером микромира, в котором блоки можно было складывать и сортировать, а также проводить эксперименты по обучению машин принятию решений. Достижения, созданные с помощью библиотек, таких как SHRDLU помогло продвинуть обработку языка вперед.

🎥 Нажмите на изображение выше для просмотра видео: Мир блоков SHRDLU

1974-1980: "Зима искусственного интеллекта"

К середине 1970-х годов стало очевидно, что сложность создания "интеллектуальных машин" была занижена и что ее перспективы, учитывая доступные вычислительные мощности, были преувеличены. Финансирование иссякло, и доверие к этой области снизилось. Некоторые проблемы, повлиявшие на доверие, включали:

- Ограничения. Вычислительная мощность была слишком ограничена.

- Комбинаторный взрыв. Количество параметров, необходимых для обучения, росло экспоненциально по мере того, как усложнялись задачи для компьютеров, без параллельной эволюции вычислительной мощности и возможностей.

- Нехватка данных. Нехватка данных затрудняла процесс тестирования, разработки и совершенствования алгоритмов.

- Задаем ли мы правильные вопросы?. Сами вопросы, которые задавались, начали подвергаться сомнению. Исследователи начали подвергать критике свои подходы:

- Тесты Тьюринга были поставлены под сомнение, среди прочего, с помощью "теории китайской комнаты", которая утверждала, что "программирование цифрового компьютера может создать впечатление, что он понимает язык, но не может обеспечить реальное понимание". (источник)

- Этика внедрения в общество искусственного интеллекта, такого как "терапевт" ЭЛИЗА, была поставлена под сомнение.

В то же время начали формироваться различные школы ИИ. Произошло разделение на подходы "неряшливого" и "чистого" ИИ. Приверженцы неряшливого ИИ часами корректировали программы, пока не получали желаемых результатов. Приверженцы Чистого ИИ были "сосредоточены на логике и решении формальных задач". ЭЛИЗА и SHRDLU были хорошо известными неряшливыми системами. В 1980-х годах, когда возник спрос на то, чтобы сделать системы машинного обучения воспроизводимыми, Чистый подход постепенно вышел на передний план, поскольку его результаты более объяснимы.

Экспертные системы 1980-х годов

По мере роста отрасли ее преимущества для бизнеса становились все более очевидными, а в 1980-х годах - и распространение "экспертных систем". "Экспертные системы были одними из первых по-настоящему успешных форм программного обеспечения искусственного интеллекта (ИИ)". (источник).

Этот тип системы на самом деле был гибридным, частично состоящим из механизма правил, определяющего бизнес-требования, и механизма вывода, который использует систему правил для вывода новых фактов.

В эту эпоху также все большее внимания уделялось нейронным сетям.

1987 - 1993: 'Охлаждение' к ИИ

Распространение специализированного оборудования экспертных систем привело к печальному результату - оно стало слишком специализированным. Появление персональных компьютеров конкурировало с этими крупными специализированными централизованными системами. Началась демократизация вычислительной техники, и в конечном итоге она проложила путь к современному взрыву больших данных.

1993 - 2011

Эта эпоха ознаменовала новую эру для ML и ИИ, которые смогли решить некоторые проблемы, возникавшие ранее из-за нехватки данных и вычислительных мощностей. Объем данных начал быстро увеличиваться и становиться все более доступным, и к лучшему и к худшему, особенно с появлением смартфона примерно в 2007 году. Вычислительная мощность росла экспоненциально, и вместе с ней развивались алгоритмы. Эта область начала набирать зрелость по мере того, как свободные дни прошлого начали превращаться в настоящую дисциплину.

Сейчас

Сегодня машинное обучение и искусственный интеллект затрагивают практически все сферы нашей жизни. Текущая эпоха требует тщательного понимания рисков и потенциальных последствий этих алгоритмов для человеческих жизней. Как заявил Брэд Смит из Microsoft, "Информационные технологии поднимают проблемы, которые лежат в основе защиты основных прав человека, таких как конфиденциальность и свобода выражения мнений. Эти проблемы повышают ответственность технологических компаний, которые создают эти продукты. На наш взгляд, они также требуют продуманного государственного регулирования и разработки норм, касающихся приемлемых видов использования" (источник).

Еще предстоит увидеть, что ждет нас в будущем, но важно понимать эти системы, а также программное обеспечение и алгоритмы, которыми они управляют. Мы надеемся, что эта учебная программа поможет вам лучше понять, чтобы вы могли принять решение самостоятельно.

🎥 Нажмите на изображение выше, чтобы посмотреть видео: Yann LeCun обсуждает историю глубокого обучения в этой лекции

🚀Вызов

Погрузитесь в один из этих исторических моментов и узнайте больше о людях, стоящих за ними. Есть увлекательные персонажи, и ни одно научное открытие никогда не создавалось в культурном вакууме. Что вы обнаружите?

Тест после лекции

Обзор и самообучение

Вот что можно посмотреть и послушать:

Этот подкаст, в котором Эми Бойд обсуждает эволюцию ИИ